1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

|

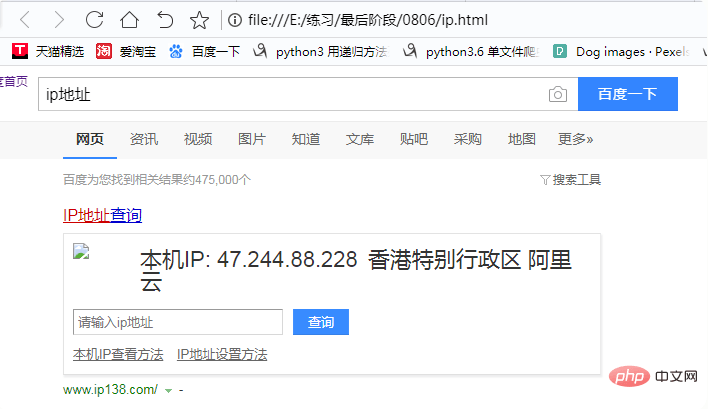

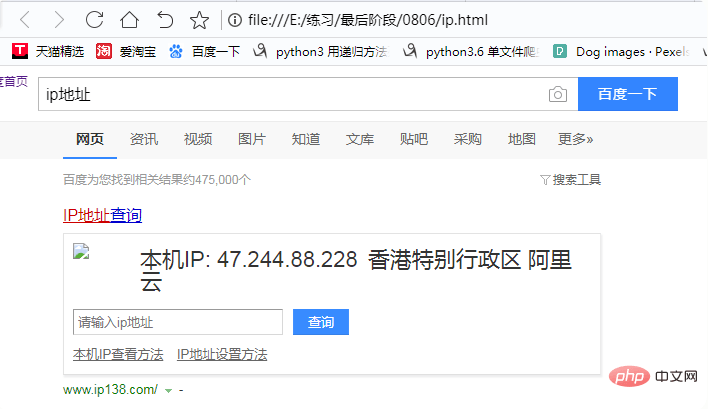

打开存入的“ip.html”查看内容如下;

以上就是python爬虫如何设置代理ip的详细内容,更多文章请关注木庄网络博客!!

相关阅读 >>

从此驾驭图表的神器matplotlib,Python强大的作图工具

更多相关阅读请进入《Python》频道 >>

Python编程 从入门到实践 第2版

python入门书籍,非常畅销,超高好评,python官方公认好书。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

|

打开存入的“ip.html”查看内容如下;

以上就是python爬虫如何设置代理ip的详细内容,更多文章请关注木庄网络博客!!

相关阅读 >>

从此驾驭图表的神器matplotlib,Python强大的作图工具

更多相关阅读请进入《Python》频道 >>

python入门书籍,非常畅销,超高好评,python官方公认好书。

管理员已关闭评论功能...