本文摘自php中文网,作者不言,侵删。

本篇文章给大家带来的内容是关于Python抓取网页乱码的原因及解决方法,有一定的参考价值,有需要的朋友可以参考一下,希望对你有所帮助。在用 python2 抓取网页的时候,经常会遇到抓下来的内容显示出来是乱码。

发生这种情况的最大可能性就是编码问题: 运行环境的字符编码和网页的字符编码不一致。

比如,在 windows 的控制台(gbk)里抓取了一个 utf-8 编码的网站。或者,在 Mac / Linux 的终端(utf-8)里抓取了一个 gbk 编码的网站。因为多数网站采用 utf-8 编码,而不少人又是用 windows,所有这种情况相当常见。

如果你发现你抓下来的内容,看上去英文、数字、符号都是对的,但中间夹杂了一些乱码,那基本可以断定是此情况。

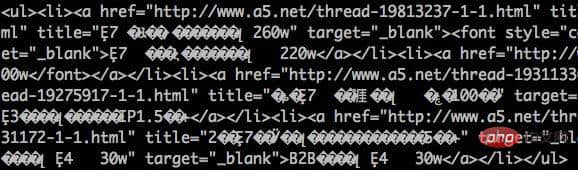

解决这个问题的办法就是,把结果先按网页的编码方式 decode 解码成 unicode,再输出。如果不确定网页的编码,可参照以下代码:

1 2 3 4 5 6 |

|

'ignore' 参数的作用是忽略掉无法解码的字符。

不过这种方法不总是有效。还有种方式就是通过正则直接匹配网页代码中的编码设置:

1 |

|

除了编码问题造成乱码之外,还有种常被忽视的情况,就是 目标网页启用了 gzip 压缩 。压缩后的网页传输数据少了,打开速度更快。在浏览器中打开时,浏览器会根据网页的 header 信息自动做解压。但直接用代码抓取则不会。因此很可能就被搞糊涂了,为什么明明打开网页地址是对的,但程序抓取就不行。连我自己也曾经被这个问题坑过。

这种情况的表现是抓取的内容几乎全是乱码,甚至无法显示。

相关阅读 >>

Python通过公共键对字典列表排序(利用itemgetter函数)

更多相关阅读请进入《Python》频道 >>

Python编程 从入门到实践 第2版

python入门书籍,非常畅销,超高好评,python官方公认好书。