本文摘自php中文网,作者不言,侵删。

这篇文章主要介绍了关于用TensorFlow实现lasso回归和岭回归算法的示例,有着一定的参考价值,现在分享给大家,有需要的朋友可以参考一下也有些正则方法可以限制回归算法输出结果中系数的影响,其中最常用的两种正则方法是lasso回归和岭回归。

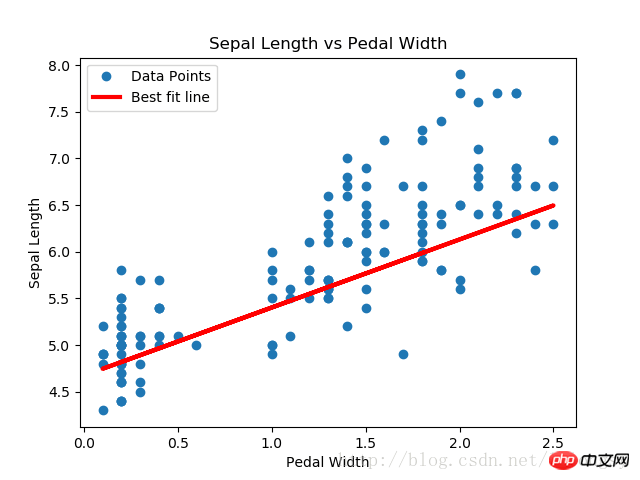

lasso回归和岭回归算法跟常规线性回归算法极其相似,有一点不同的是,在公式中增加正则项来限制斜率(或者净斜率)。这样做的主要原因是限制特征对因变量的影响,通过增加一个依赖斜率A的损失函数实现。

对于lasso回归算法,在损失函数上增加一项:斜率A的某个给定倍数。我们使用TensorFlow的逻辑操作,但没有这些操作相关的梯度,而是使用阶跃函数的连续估计,也称作连续阶跃函数,其会在截止点跳跃扩大。一会就可以看到如何使用lasso回归算法。

对于岭回归算法,增加一个L2范数,即斜率系数的L2正则。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 |

|

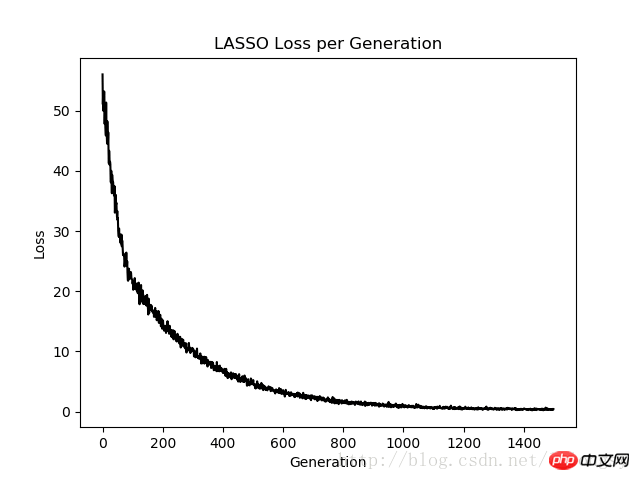

输出结果:

Step #300 A = [[ 0.77170753]] b = [[ 1.82499862]]

Loss = [[ 10.26473045]]

Step #600 A = [[ 0.75908542]] b = [[ 3.2220633]]

Loss = [[ 3.06292033]]

Step #900 A = [[ 0.74843585]] b = [[ 3.9975822]]

Loss = [[ 1.23220456]]

Step #1200 A = [[ 0.73752165]] b = [[ 4.42974091]]

Loss = [[ 0.57872057]]

Step #1500 A = [[ 0.72942668]] b = [[ 4.67253113]]

Loss = [[ 0.40874988]]

通过在标准线性回归估计的基础上,增加一个连续的阶跃函数,实现lasso回归算法。由于阶跃函数的坡度,我们需要注意步长,因为太大的步长会导致最终不收敛。

相关推荐:

用TensorFlow实现戴明回归算法的示例

以上就是用TensorFlow实现lasso回归和岭回归算法的示例的详细内容,更多文章请关注木庄网络博客!!

相关阅读 >>

介绍使用Python的statsmodels模块拟合arima模型

Python三大框架:flask框架、tornado框架、django框架简介

更多相关阅读请进入《Python》频道 >>

Python编程 从入门到实践 第2版

python入门书籍,非常畅销,超高好评,python官方公认好书。