本文摘自雷锋网,原文地址:https://www.leiphone.com/category/chips/2NHM9jDdB6f8O796.html,侵删。

英伟达GPU在AI领域的成功引来了大量的挑战者。在国外,云端芯片初创公司几乎都采用DSA(Domain Specific Architecture,领域专用架构)挑战英伟达,比如已经被英特尔收购的Habana Labs。在国内,也有多家初创公司用GPGPU的架构研发AI云端芯片。

“用相同的架构竞争,专利就是一个问题。DSA是不同的道路,特别在云端AI推理方面,DSA可以完胜GPU。” 瀚博半导体创始人兼CEO钱军解释了创业前的技术路线思考。

雷锋网此前的文章介绍过,钱军有25年以上高端芯片设计经验,离职前在AMD任Senior Director,全面负责GPU(图像处理器)和AI服务器芯片设计和生产,现在市场上的AMD Radeon图像处理器和AI服务器芯片都是由其带队开发。

瀚博半导体创始人兼CEO钱军

瀚博的另一个创始人,也是CTO和总架构师的张磊有23年以上芯片和IP架构设计的丰富经验,2013年晋升为AMD Fellow,负责AI、深度学习,视频编解码和视频处理领域。

外界不少人误以为有多款GPU成功经验的两位创始人会选择用GPU挑战英伟达,但瀚博在2021世界人工智能大会(WAIC 2021)开幕前夕发布的首款产品SV102云端推理芯片采用的是DSA架构,而这款AI芯片获取客户的秘诀是TCO(Total Cost of Ownership,总体拥有成本)。

GPU不是云端推理最好的架构

初创公司要与巨头竞争,差异化是必然的选择。对于芯片公司而言,市场规模和技术路线是关键的考量因素。就云端芯片而言,随着AI模型的成熟,市场对云端AI训练需求的增速会降低,云端AI推理的市场规模将会迅速增加。有数据显示,2021年云端推理芯片市场已经大于训练市场。

云端AI芯片市场的变化是挑战英伟达的一个好机会。根据MLPerf此前发布的基准测试,英伟达在训练测试中一直保持着较高的水平,但在推理测试中,GPU并不如其在训练中的表现那么亮眼。

本月初,英国初创公司Graphcore的IPU首度公开MLPerf基准测结果,结果显示在Inference v1.0基准测试下,IPU相比GPU有1倍多的性价比收益。

“GPU在推理侧不是最好的架构,我们更好的DSA架构,能够在云端推理市场完胜GPU。”钱军表示。

但即便如此,能够定义和推出客户愿意买单的AI推理芯片才能够挑战英伟达。钱军分享了他的一些思考。他表示,计算机视觉占了AI市场的大半壁江山,视频流又占近70%的数据流,未来视频相关的数据只会越来越多,因此基于视频的AI应用首先要有强大的解码能力。

钱军认为,AI芯片视频处理能力可以用三个指标去衡量,包括延迟、吞吐量和能效。

当然,芯片的性能也是核心指标,同时,对于各种数据类型和AI模型的支持也是吸引客户的关键。钱军介绍,“我们的产品对于支持主流AI模型很全面,芯片设计也有前瞻性,支持计算机视觉、自然语言处理、搜索推荐、智能视频处理领域的众多常用神经网络,软件栈支持灵活扩展,支持用户自定义算子。”

云端推理DSA架构芯片完胜GPU

英伟达的众多挑战者中,有底气说出完胜的公司并不多。雷锋网(公众号:雷锋网)了解到,瀚博的首款芯片研发周期大概是两年半,这也是业界高性能芯片普遍的研发周期。2018年底瀚博半导体创立之后,瀚博的团队就开始自主IP的研发,到了今年6月份,首款芯片SV102测试成功。

“SV102开始测试后的8分钟就全部点亮,也就是通过PCIe就能看到所有功能模块,在30多个小时内,所有模块基础测试都提前完成。”钱军说,“这对于一个全新设计的高端芯片是一个奇迹。”

虽然钱军没有具体介绍瀚博的DSA架构,不过CTO张磊用一组数据展示了瀚博首款产品相比GPU的竞争优势。

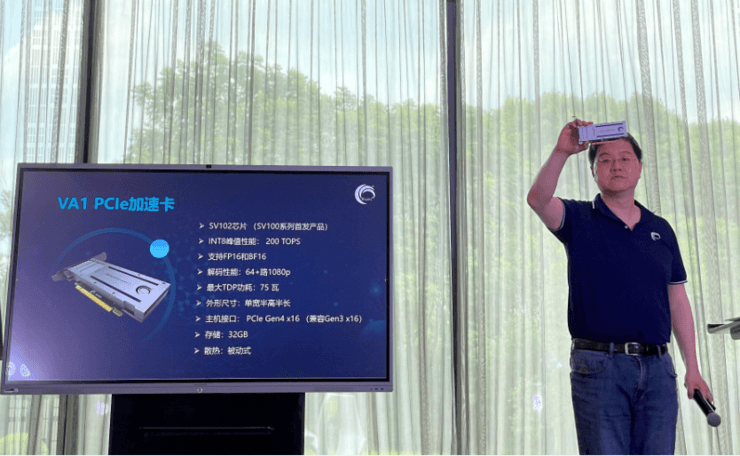

瀚博SV102是面向云端高性能推理的AI芯片,强调AI推理、视频处理以及可扩展性三大能力。AI推理性能表现在高效、高能耗比和低延时三方面,具体而言,SV102在Int8精度下的峰值性能为200TOPS,在75功耗下,吞吐率是GPU的2-10倍,延时更是不到GPU的5%。

瀚博半导体创始人兼CTO张磊

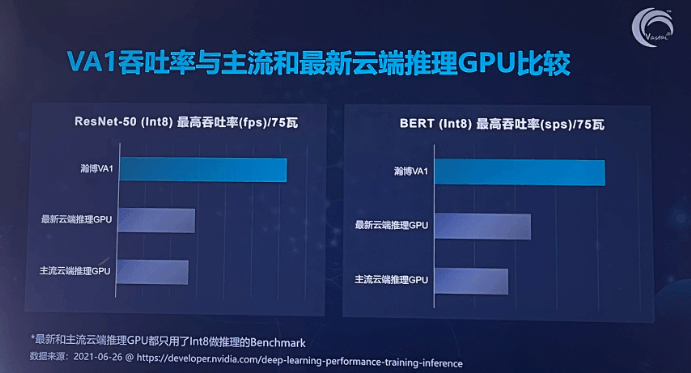

张磊介绍,SV102采用的是单宽半高半长的设计,存储最高支持32GB,接口是16个PCIe Gen4,采用被动散热的方式。之所以单独给出Int8的性能数据是因为最新和主流云端推理GPU都只用了Int8做推理基准测试,SV102也支持FP16和BF16的数据类型。

从给出的数据可以看到,在ResNet50和BERT两个模型下,瀚博SV102对比英伟达最新的A10和主流的T4有2-10倍的性能优势。

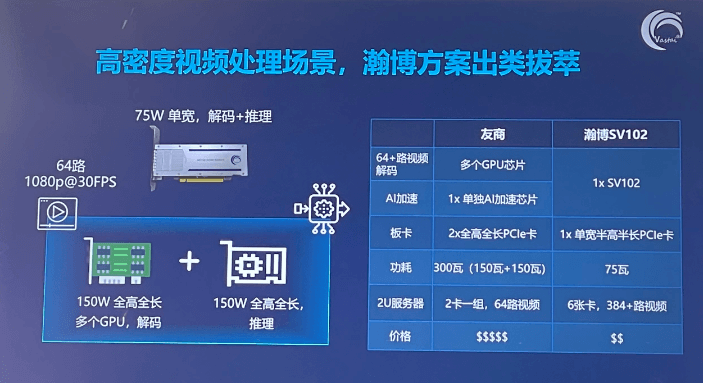

视频处理则是瀚博AI芯片的一大特色。“国内外已经推出的云端AI推理芯片几乎都没有内置视频解码功能,如果客户需要做视频解码,就需要用单独的芯片进行解码。SV102就支持64路以上H.264、H.265或AVS2 1080P解码,支持8K分辨率。”张磊表示。

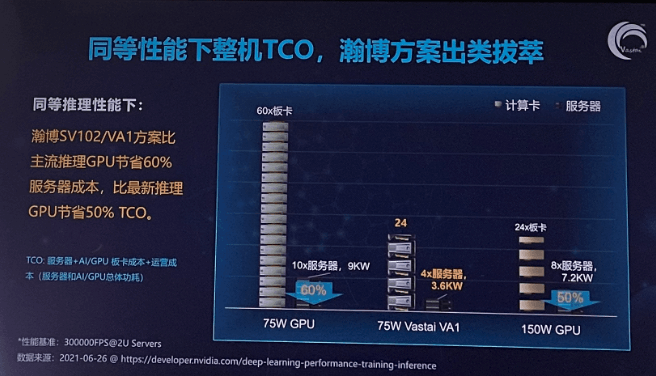

由此带来的是TCO的优势,这里的TCO主要包含服务器+AI芯片+芯片功耗+运营成本。张磊给出的测算是,基于SV102的性能、功耗以及尺寸的特性,相比T4的服务器可以节省60%以上的TCO,对比A10的服务器也可以节省50%的成本。在高密度视频处理场景,瀚博给出的数据也显示出其性能和价格的优势。

即便从产品性能层面瀚博有完胜GPU的信心,但客户的认可才是最终的成功。所以,首要问题就是客户的迁移成本。张磊告诉雷锋网:“从AI推理的角度看,迁移到我们的AI芯片上的成本比较小。对于那些有自己算法的客户,迁移的成本也是很小的一部分。更重要的是要让客户看到TCO的巨大节省,这样对于客户来说才能具有足够的吸引力,应用落地也会非常快。”

钱军补充表示:“一定要理解客户的需求,然后针对需求投入精力。”

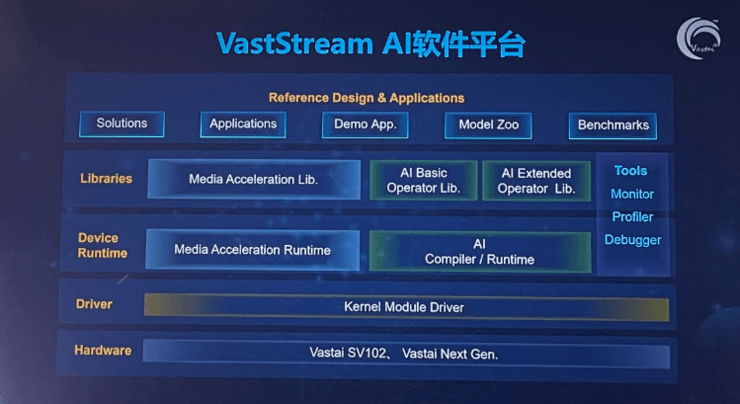

对于瀚博来说,就是尽快完善软件和生态的建设。瀚博的VastStream软件平台支持TensorFlow、 PyTorch、Caffe2等常见的深度学习框架模型与ONNX格式的模型,借助高度定制的AI编译器可以充分优化模型的执行效率。

钱军介绍,“我们在互联网侧的落地速度更快一些,现已与国内外多家头部互联网公司合作。同时,我们还在大力增加软件团队,未来软件人员的数量会是硬件团队规模的3-5倍。”

虽然钱军没有透露具体的合作客户,不过快手作为瀚博的A轮投资人,双方应该在业务上更容易达成合作。但无论如何,瀚博的首款芯片的大规模落地还有一段距离。

“瀚博今年的产能已经确定,明年大部分的产能也已经提前预知。”钱军透露。

今年四月份第一次和钱军深度对话的时候,对于其产品钱军仅仅透露了技术路线的选择。在首款产品流片和完成测试之后,瀚博对外透露了有限的产品信息,但核心的架构以及内置多路视频解码能力的特性并未公布更多消息,雷锋网认为这些才是瀚博最核心的竞争力。

当然,对于互联网客户以及行业客户而言,TCO以及易用程度才是更直接的考量因素。瀚博能否用TCO打动足够多的客户,仍需观察。但同样值得关注的是,在瀚博的产品规划里,有15瓦到150瓦的硬件产品,覆盖边缘和云端。

雷锋网原创文章,未经授权禁止转载。详情见转载须知。

相关阅读 >>

一汽大众金融全国官方客服电话大全已更新2023(实时/更新中)工信部发布《对地静止轨道卫星动中通地球站管理办法》

更多相关阅读请进入《新闻资讯》频道 >>