本文摘自雷锋网,原文链接:https://www.leiphone.com/category/academic/jigzKdy1fsZkMvUq.html,侵删。

语言模型越大,其自我验证能力越强,推理性能也更高。

推理能力是机器接近人类智能的一个重要指标。

最近的大型语言模型(Large language mode,LLM)正在变得越来越擅长推理,背后的一个关键技术是思维链(chain-of-thought,CoT),简单来说,CoT 可以让 LLM 模拟人类思考的过程,帮助大型语言模型生成一个推理路径,将复杂的推理问题分解为多个简单的步骤,而不仅仅只是一个最终答案,从而增强模型的推理能力。

对人类而言,我们推断得出一个结论后,往往会通过重新验证来进行核对、避免错误。但当 LLM 在通过 CoT 执行复杂推理尤其是算术和逻辑推理的过程中若出现错误,会在一定程度上影响推理效果,所以不得不进行人工验证。

那么能不能让语言模型也具备自我纠错和自我验证的能力呢?

近日,中国科学院自动化所的研究团队提出了一种新方法证明了 LLM 可对自己的推理结论进行可解释的自我验证,从而大大提高推理性能,这让 LLM 朝着人类智能又前进了一步。

1 正向推理+反向验证

当涉及复杂推理时,语言模型往往缺乏稳健性,一旦发生任何一个小错误,都可能会改变命题的全部含义,从而导致出现错误答案。使用CoT 提示进行推理时,问题会更严重,由于模型没有纠错机制,以至于很难从错误的假设中纠正过来。

以往的一种解决方法是通过训练验证器(verififiers)来评估模型输出正确性。但训练验证器有三个大缺点:需要大量的人力和计算资源、可能存在误报、可解释性差。

为此,中科院团队提出让 LLM 进行自我验证。

首先,假设推理问题中的所有条件对于得出结论都是必要的,给定结论和其他条件后,可推导出其余条件。自我验证分两个阶段进行:

正向推理,LLM 生成候选思维链和结论给定的问题文本; 反向验证,使用 LLM 来验证条件是否满足候选结论,并根据验证分数对候选结论进行排序。

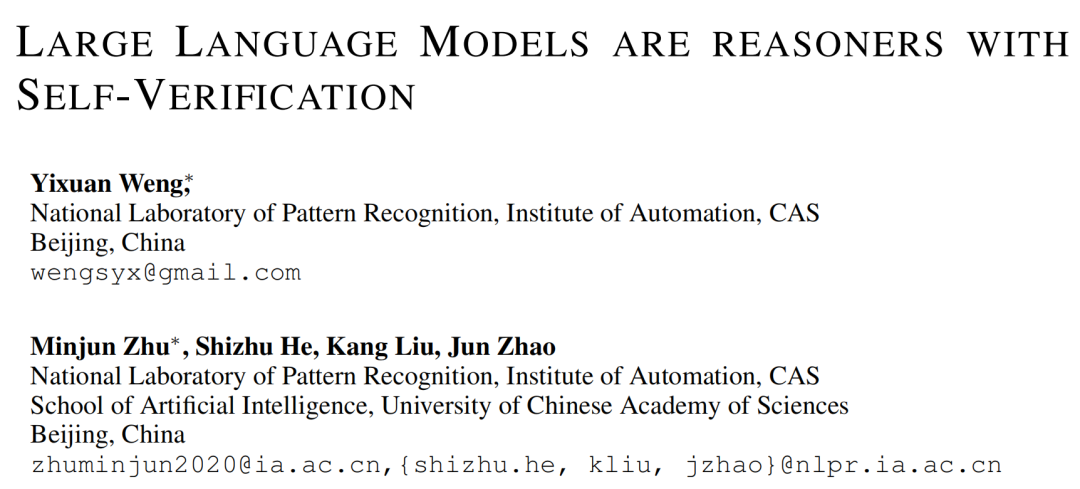

如下图,对于“Jackie 有 10 个苹果(f1),Adam 有 8 个苹果(f2),Jackie 比 Adam 多了多少个苹果?”这个问题,可从 f1 和 f2 推理出结论 fy。然后,通过反向验证来检验该结论的准确性,就像解方程一样,如果以 f2 和 fy 为条件,可以得出 f1,通过验证 f1 是否与原来的 f1 结果一致,可以判断 fy 的正确性。

图 1:正向推理与反向验证

研究表明,LLM 仅需少量提示即可使用自我验证,无需训练或梯度更新。它们用候选结论来验证,解决了原 CoT 中偏离正确思维过程的问题。而且,验证分数源自整个思维推理过程,可解释性很高。

通过对 GPT‑3、CODEX 和 Instruct‑GPT 等大模型的实验分析,这项研究证明了 LLM 具备可解释的自我验证能力。

2 LLM 的自我验证过程

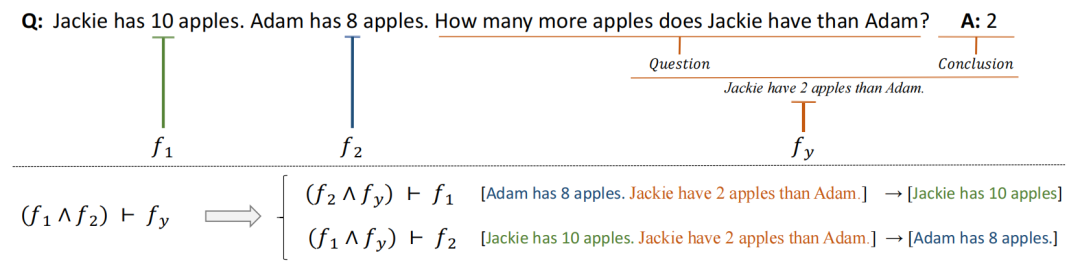

自我验证的整个过程如图 2所示。第一步与 CoT 类似,但研究通过采样解码生成多个候选结论,计算每个候选结论的验证分数,并选择最高分数作为最终结论。

图 2:自我验证示例;LLM 在第一阶段中生成一些候选结论,三个预训练语言模型用于大量自动构建的数值推理问题,但这些方法需要大量的数据和专家注释,然后 LLM 依次验证这些结论,统计推理正确的屏蔽条件的个数作为第二阶段的验证分数

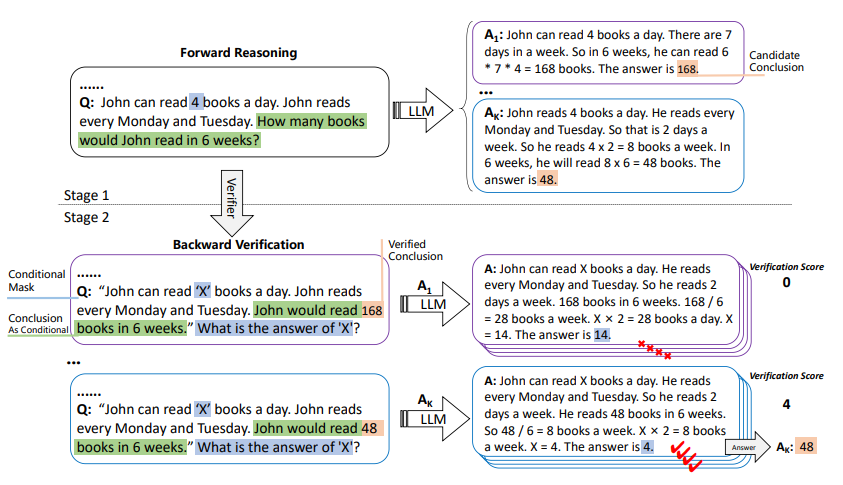

图 3:这是一个需要使用多个条件的示例;如果只屏蔽第一个证据,则不需要这个证据(前向推理时,需要计算周末的钱,周五的工作时数不影响最终结论)。因此,我们无法根据现有条件和任何候选结论来预测此证据

2.1 候选结论生成

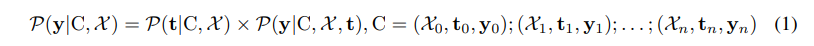

给定一个语言模型 M 和一个问答数据集 D,CoT 为 D 设计了一组样本 C,其中包含 n 个样本,epoch 样本有包含条件和问题的输入 X,思维过程 t 和结论 y。这些示例用作测试时间的输入。通常 n 是一位数,因此需要语言模型 M 在生成 y 之前安装 C 生成 t 的提示:

C 中的每个示例都连接为提示。

使用 Sampling 解码生成 K y,K 是 y 的个数。具体来说,采样译码是一种随机译码方法,它可以在每一步从可能生成的词的概率分布中采样来选择下一个词,重复使用 Sampling 解码可以得到多个候选结论。

2.2 条件和结论的重写

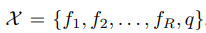

对输入的 X 进一步细分为其中每个 f 是一个条件,q 是一个问题。我们使用命令“请把问题和答案改成完整的陈述句[q] The answer is [y]”通过 M 把 q 和 y 改成新的陈述句 fy 。

在问题生成上,问题的多样性使得在实际操作中很难平衡问题和答案之间的连贯性和事实一致性的需要,因此直接屏蔽条件。首先,通过正则匹配找到 f1 中的值改写为 X,在新问题的末尾加入“What is the answer of X?” ,从而提示语言模型指示目标。

如图 4 所示,如果给定的 X 不满足所有条件都是结论的必要条件,可以发现只有掩码的第一个条件会有局限性,难以准确评估其验证分数。为了解决这个问题,可以采用多个条件依次验证的方法:依次用 X 替换原始 X 中出现的所有 f,并要求 M 重新预测它,提高验证的可靠性和准确性。

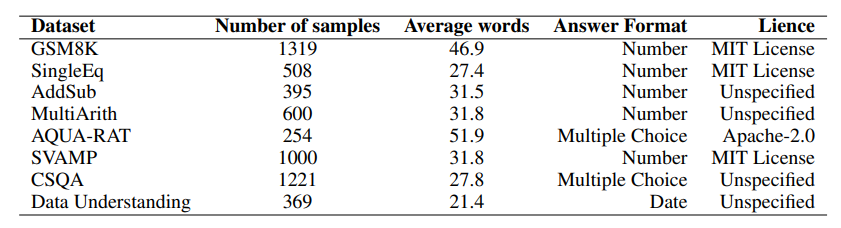

图 4:在八个基准数据集上进行评估,这些基准数据集涵盖了算术推理、常识推理和逻辑推理任务

研究人员设计了一个类似于正向推理的 CoT 以指导 LLM 生成解决过程。而反向验证过程类似于求解方程式,可将其最终结果与屏蔽条件进行匹配。

相关阅读 >>

瑞莱智慧完成超3亿元a轮融资,加大AI安全、隐私计算等平台产品研发投入

刚破两千亿,4年后又要翻倍,上海AI定下这些目标,到2025年一起见证

突发!影像AI公司汇医慧影被黑客入侵,新冠研究成果被公开出售

更多相关阅读请进入《AI》频道 >>